L’accélération d’inférence est une technologie prometteuse, qui ouvre de nombreuses perspectives mais qui pose également de nombreuses questions.

Le principe général de l’accélération d’inférence est en fait très simple : imiter le fonctionnement du cerveau humain.

Cette imitation prend la forme d’un mécanisme de suppression en continu des connexions et des neurones les moins utilisés dans un algorithme de Deep Learning.

Le résultat théorique est donc une très grande économie de puissance, avec des résultats presque identiques.

L’idée de base est très bonne, mais comme toujours c’est l’exécution qui pose problème. Le processus d’accélération d’inférence est très coûteux en énergie, ce qui limite son déploiement.

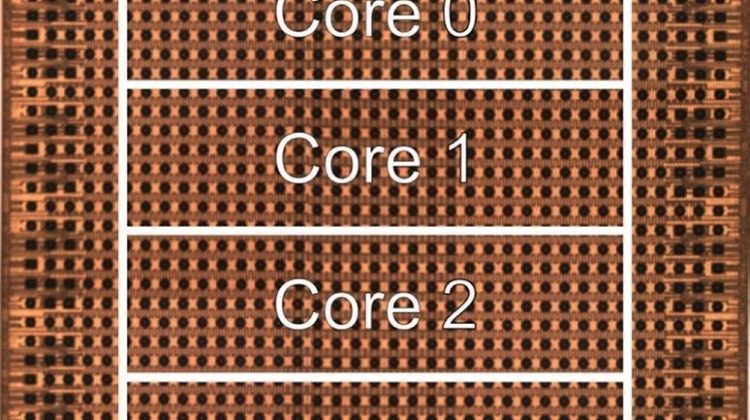

Face à ce problème, IBM a annoncé avoir conçu une puce nouvelle génération, économe en énergie et entièrement dédiée à l’accélération d’inférence hardware.

Cette puce, qui n’a pas encore de nom, propose un rapport puissance/consommation 3 fois supérieur aux standards du marché.

Un sujet d’experts qui n’intéresse personne ? L’accélération d’inférence est déjà couramment utilisée dans certains domaines, dont la voiture autonome, et le coût énergétique est l’un des derniers freins à son adoption massive dans de nombreux autres secteurs…

Source : https://www.ibm.com/blogs/research/2021/02/ai-chip-precision-scaling/

Post original : https://www.linkedin.com/posts/guillaumebesson_lacc%C3%A9l%C3%A9ration-dinf%C3%A9rence-est-une-technologie-activity-6770971917345144832-ml_R