O sistema de reconhecimento de imagem visa aprender sobre essas imagens sem algum conhecimento especializado prévio, no entanto, pesquisas sugerem que os sistemas de Machine Learning podem ter resultados tendenciosos.

Esses sistemas acabam buscando e reproduzindo padrões nos dados que são treinados, e é daí que surge essa disparidade em como os algoritmos rotulam imagens de homens e mulheres. Como esses dados de entrada são “importados” da realidade, muitos dos preconceitos e associações culturais das sociedades são transportados para esses sistemas.

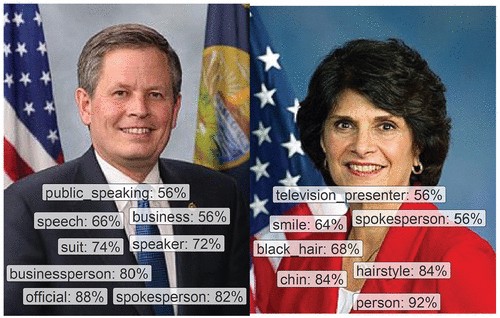

Em estudo realizado por Carsten Schwemmer em conjunto com outros pesquisadores, foi utilizado dois conjuntos de imagens associadas a legisladores: tanto em imagens deles quanto imagens tuitadas por eles na internet. Como resultado, esses serviços de IA notavam homens e mulheres de maneiras diferentes, sendo que as mulheres eram muito mais prováveis em serem caracterizadas por adjetivos ligados à aparência (em tags como “menina”, “beleza” e “sorriso”, por exemplo, enquanto homens receberam tags como “empresários” e “oficial”) e até mesmo a não detectá-las com uma maior frequência que os homens.

Embora não sejam tags necessariamente erradas (muitos desses legisladores são homens de negócios e muitas dessas legisladoras têm cabelos castanhos, por exemplo), é perceptível ver o machismo transportado para o algoritmo ao perceber que tags relacionadas à aparência são muito mais presentes nas imagens de mulheres, enquanto tags relacionadas a status profissional e de classe são mais presentes nas imagens de homens.

Para acompanhar o estudo completo, acesse: